终端侧的轻量化应用

展开

$C中电港(sz001287)$

电子行业专题研究:关注AI大模型在终端侧的轻量化应用

高通、华为实现AI大模型在终端的轻量化部署,关注边/端侧算力机会

3月2日,高通在MWC 2023大会发布全球首个运行在Android手机上的Stable Diffusion终端侧演示,Stable Diffusion模型参数超过10亿,高通利用其AI软件栈对模型进行量化、编译和硬件加速优化,使其成功在搭载第二代骁龙8移动平台的手机上运行。此外,华为新一代P60系列手机将于5月上线智慧搜图功能,该功能通过对模型进行小型化处理,实现其在端侧轻量化应用。我们认为模型压缩技术是实现AI大模型在边/端部署的核心技术。当前,谷歌、微软、腾讯等厂商在该领域均有布局,将加速AI技术与智能终端融合,国内SoC设计公司有望深度受益。模型压缩技术:有效降低推理算力需求,助力大模型的边/端侧部署模型压缩技术可在保有大模型原有性能和精度基本不变前提下降低对推理算力的需求:1)量化:将浮点计算转成低比特定点计算;2)网络剪枝:去除神经网络中冗余的通道、神经元节点等;3)知识蒸馏:将大模型作为教师模型,用其输出训练性能接近、结构更简的学生模型。以清华大学唐杰教授团队2022年8月发布的1300亿参数模型GLM-130B为例,原模型支持在一台A100(40G8)或V100(32G8)服务器上进行推理,而将模型量化至INT4精度后,相较INT8精度其所需GPU内存降低50%,且可在一台4×RTX 3090(24G)或8×RTX 2080Ti(11G)服务器上进行推理。全球洞察:谷歌等已将模型压缩技术紧密结合移动端模型部署框架/工具上世纪学术界率先提出网络剪枝技术,并一直引领模型压缩技术的突破。业界的发展紧随其后,并进一步将模型压缩技术集成至移动端模型部署框架/工具,主要参与者包括:1)深度学框架厂商:谷歌(MLKit)、Meta(PyTorchMobile);2)硬件厂商:英伟达(TensorRT)、英特尔(NNCF)、高通(AIMET)等;以及3)云服务厂商:微软(ONNXRuntime)等。以谷歌2018年推出的MLKit为例,核心功能Learn2Compress模型压缩技术结合网络剪枝、量化以及知识蒸馏三项技术,可实现在CIFAR-10图像分类测试任务中生成较NASNet尺寸缩小94倍的轻量化模型,且仍保持90%以上精度。国内现状:互联网厂商引领发展,国内SoC设计企业有望受益腾讯、百度为代表的国内互联网厂商在模型压缩技术上也取得长足进展。2018年腾讯推出全球首款自动化深度学模型压缩框架PocketFlow,2022年百度开源的文心ERNIE-Tiny在线蒸馏方案可得到参数规模仅为原模型0.02%且效果相当的轻量级模型。我们认为伴随模型压缩技术发展,AI将加速与终端设备融合应用,国内相关领域布局公司包括:晶晨股份(机顶盒/电视/音箱SoC),全志科技(国内音箱SoC龙头),瑞芯微(AIOTSoC芯片)、恒玄科技(可穿戴蓝牙音频SoC)、炬芯科技(智能音频SoC)、乐鑫科技(国内Wi-Fi MCU龙头)、中科蓝讯(可穿戴蓝牙音频SoC)等。风险提示:中美贸易摩擦加剧风险;AI及技术落地不及预期;本研报中涉及到未上市公司或未覆盖个股内容,均系对其客观公开信息的整理,并不代表本研究团队对该公司、该股票的推荐或覆盖。

电子行业专题研究:关注AI大模型在终端侧的轻量化应用

高通、华为实现AI大模型在终端的轻量化部署,关注边/端侧算力机会

3月2日,高通在MWC 2023大会发布全球首个运行在Android手机上的Stable Diffusion终端侧演示,Stable Diffusion模型参数超过10亿,高通利用其AI软件栈对模型进行量化、编译和硬件加速优化,使其成功在搭载第二代骁龙8移动平台的手机上运行。此外,华为新一代P60系列手机将于5月上线智慧搜图功能,该功能通过对模型进行小型化处理,实现其在端侧轻量化应用。我们认为模型压缩技术是实现AI大模型在边/端部署的核心技术。当前,谷歌、微软、腾讯等厂商在该领域均有布局,将加速AI技术与智能终端融合,国内SoC设计公司有望深度受益。模型压缩技术:有效降低推理算力需求,助力大模型的边/端侧部署模型压缩技术可在保有大模型原有性能和精度基本不变前提下降低对推理算力的需求:1)量化:将浮点计算转成低比特定点计算;2)网络剪枝:去除神经网络中冗余的通道、神经元节点等;3)知识蒸馏:将大模型作为教师模型,用其输出训练性能接近、结构更简的学生模型。以清华大学唐杰教授团队2022年8月发布的1300亿参数模型GLM-130B为例,原模型支持在一台A100(40G8)或V100(32G8)服务器上进行推理,而将模型量化至INT4精度后,相较INT8精度其所需GPU内存降低50%,且可在一台4×RTX 3090(24G)或8×RTX 2080Ti(11G)服务器上进行推理。全球洞察:谷歌等已将模型压缩技术紧密结合移动端模型部署框架/工具上世纪学术界率先提出网络剪枝技术,并一直引领模型压缩技术的突破。业界的发展紧随其后,并进一步将模型压缩技术集成至移动端模型部署框架/工具,主要参与者包括:1)深度学框架厂商:谷歌(MLKit)、Meta(PyTorchMobile);2)硬件厂商:英伟达(TensorRT)、英特尔(NNCF)、高通(AIMET)等;以及3)云服务厂商:微软(ONNXRuntime)等。以谷歌2018年推出的MLKit为例,核心功能Learn2Compress模型压缩技术结合网络剪枝、量化以及知识蒸馏三项技术,可实现在CIFAR-10图像分类测试任务中生成较NASNet尺寸缩小94倍的轻量化模型,且仍保持90%以上精度。国内现状:互联网厂商引领发展,国内SoC设计企业有望受益腾讯、百度为代表的国内互联网厂商在模型压缩技术上也取得长足进展。2018年腾讯推出全球首款自动化深度学模型压缩框架PocketFlow,2022年百度开源的文心ERNIE-Tiny在线蒸馏方案可得到参数规模仅为原模型0.02%且效果相当的轻量级模型。我们认为伴随模型压缩技术发展,AI将加速与终端设备融合应用,国内相关领域布局公司包括:晶晨股份(机顶盒/电视/音箱SoC),全志科技(国内音箱SoC龙头),瑞芯微(AIOTSoC芯片)、恒玄科技(可穿戴蓝牙音频SoC)、炬芯科技(智能音频SoC)、乐鑫科技(国内Wi-Fi MCU龙头)、中科蓝讯(可穿戴蓝牙音频SoC)等。风险提示:中美贸易摩擦加剧风险;AI及技术落地不及预期;本研报中涉及到未上市公司或未覆盖个股内容,均系对其客观公开信息的整理,并不代表本研究团队对该公司、该股票的推荐或覆盖。

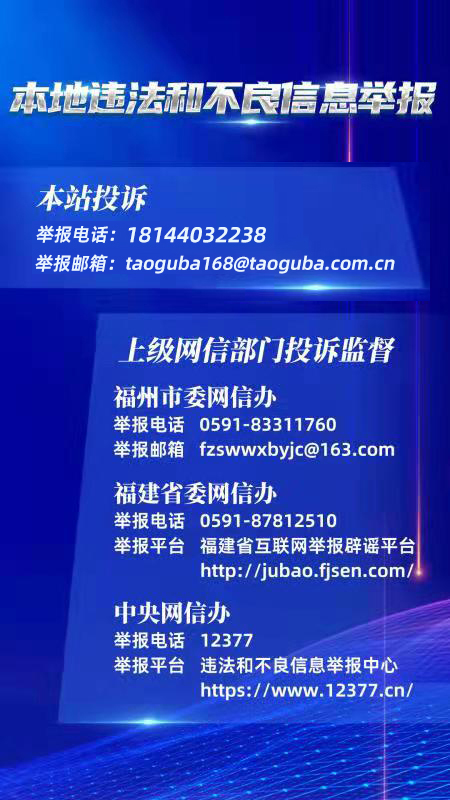

声明:遵守相关法律法规,所发内容承担法律责任,倡导理性交流,远离非法证券活动,共建和谐交流环境!